Explorations-Imagerie

Publié le 23 mar 2004Lecture 16 min

Vingt ans d’images du cœur et des vaisseaux

S. MORESTIN-CADET et J.-F. TOUSSAINT, hôpital européen Georges Pompidou, Paris

Ces 20 dernières années ont vu le foisonnement d’un nombre considérable de nouvelles techniques d’imagerie vasculaire (tomographie de cohérence optique, angioscopie, écho-élastographie, thermographie endovasculaires) et les progrès de technologies plus anciennes de l’imagerie cardiaque (rayons X pour le scanner, d’abord tomographique puis spiralé, et désormais multibarrette, isotopes avec la SPECT et la TEP, ultrasons — auquel un chapitre à part est consacré dans cette série — et IRM, récompensée par un « Nobel » 30 ans après son invention), voire leurs combinaisons telles que le TEP-scan, couplant la détection d’émetteur de positons à un scanner multibarrette, ou l’écho-thermographie en cours de développement. Par ailleurs, la place du marquage cellulaire et moléculaire (pour mettre en valeur les acteurs de l’apoptose, de l’inflammation, du remodelage et bien d’autres) reste à déterminer en pratique, mais paraît très prometteuse en termes de compréhension physiopathologique. Enfin, la télémédecine, que ce soit par les réseaux d’archivage et de traitement d’images intrahospitaliers (PACS) ou par les réseaux internationaux (dans l’aide au diagnostic ou l’établissement de banques de données à distance) a fait faire des bonds considérables dans les domaines de l’enseignement et du soin.

Angioscopie

La première angioscopie endocoronaire a été réalisée en 1985 ; rappelons toutefois que la toute première angioscopie endovasculaire le fut en 1913, avec un appareil rigide inséré par thoracotomie dans les cavités cardiaques… Ses observations, obtenues en cours d’ischémie, ont surtout permis de valider le concept d’athérothrombose avec rupture de plaque comme principal responsable des épisodes coronariens aigus (figure 2).

Cette technique repose sur l’utilisation de lumière blanche (xénon) transmise par fibres optiques jusqu’à l’extrémité distale d’un cathéter souple, couplée à une caméra vidéo. L’acquisition se fait en milieu transparent, avec injection de sérum physiologique au cours de la procédure.

Si elle souffre de limitations importantes (ostium et distalité coronaires inexplorables, vaisseaux tortueux inaccessibles à des fibres optiques encore trop rigides) avec une utilisation finalement restreinte à quelques équipes dans le monde, cette technique permet cependant d’analyser parfaitement la surface luminale des artères.

Figure 2. Angioscopie (van Belle. Circulation 1998).

Tomographie de cohérence optique

Un seul groupe a jusqu’à présent réussi à produire régulièrement ces images de très haute résolution (20 à 30 microns), supérieures aux meilleurs résultats d’échographie endocoronaire. Comme pour l’angioscopie, cette technique invasive requiert l’introduction d’un cathéter intravasculaire porteur d’une lumière monochromatique et le « lavage » régulier du conduit artériel par du sérum physiologique. Comparativement aux ultrasons, et de façon assez comparable à l’angioscopie, elle ne permet cependant qu’une exploration relativement superficielle, puisque seuls les 500 premiers microns sont accessibles à l’analyse.

Les plaques riches en macrophages y produisent un signal particulier sous forme d’une bande noire due à la réflexion importante de la lumière à l’interface collagène-lipides, et la discrimination du thrombus y est excellente (figure 3).

Elle pourrait donc être utile dans la caractérisation tissulaire de la paroi athérothrombotique, mais aucune étude n’a encore montré son intérêt pratique.

Figure 3. Athérosclérose coronaire humaine en TCO.

Écho-élastographie

Cette technique, popularisée par l’équipe du Thorax Center de Rotterdam, repose sur l’analyse simultanée de la pression artérielle et de la déformation pariétale lors des variations de contrainte systolo-diastolique (à intervalles de 100 ms et avec une résolution radiale de 200 microns) par un enregistrement ultrasonore intravasculaire (figure 4).

Elle est complémentaire de l’échographie de haute fréquence pour la description des plaques (des sondes de 30 à 50 MHz de très haute résolution spatiale sont désormais utilisées chez l’homme pour l’analyse des ruptures de plaques [figure 5]) et permettrait aussi la discrimination des plaques précoces, riches en lipides et macrophages.

Figure 4. Elastrographie in vivo (de Korte. Circulation 2002).

Figure 5. IVUS : ruptures de plaque multiples dans les SCA (Rioufo. Circulation 2002).

Thermographie endocoronaire

Initialement proposée comme indice de l’inflammation des plaques coronaires, la température de la surface artérielle peut être très précisément mesurée. De nouveaux cathéters (de type lasso à cinq thermistances en boucle) sont proposés pour en détecter d’infimes variations. Étant donné l’acuité de ces appareils, les résultats initiaux restent assez déroutants : on constate, en effet, des sautes brusques et très brèves de la température coronaire, souvent en dehors des sites de sténoses. Il n’existe par ailleurs aucun lien entre mesure thermique et statut clinique, même pour des variations, importantes à ce niveau, de plus de 0,2 °C. Celles-ci pourraient même être liées aux variations de débit coronaire (des augmentations de cet ordre ont été enregistrées lors d’interruptions transitoires du flux artériel). Enfin, comme on pouvait s’y attendre, il existe des sténoses hyperserrées sans variation thermique, sans corrélation avec la CRP ni avec le nombre de macrophages. Cela justifie de coupler cette méthode à une technique d’imagerie, quelle qu’elle soit, afin de sélectionner les régions de sténose ou d’objectiver des zones d’inflammation non sténosante pour en suivre l’évolution.

Il reste donc un très gros effort de compréhension à réaliser dans ce domaine avant que la physiopathologie de la température des plaques puisse se traduire par une approche diagnostique fiable, d’autant que le risque d’abrasion endothéliale, avec ces cathéters à cinq branches déplacées à l’aveugle, reste important.

Scanner multibarrette

C’est véritablement dans ce domaine que les dernières années ont apporté le plus de changement, non pas encore dans la pratique quotidienne, mais dans la conception que se font les cardiologues des prochaines approches non invasives. En effet, bien qu’inventée dès la fin des années 70 (figure 6), les développements de l’angiographie non invasive en IRM (figure 7) ou en scanner (figure 8) ont été très proches dans les 10 dernières années. Ces progrès parallèles reflétaient les options prises par les équipes de recherche selon le type d’exploration envisagé :

- un abord de recherche physiopathologique fondamentale en résonance magnétique, incluant l’aspect métabolique par la spectroscopie,

- ou ceux de contractilité intrapariétale avec l’imagerie de tagging,

- ou un abord plus orienté sur le diagnostic clinique avec le scanner X.

Figure 6. Scanner.

Figure 7. Angiographie.

Figure 8. Scanner multibarrette aortique.

Or, le scanner spiralé a d’abord facilité des acquisitions plus rapides avant de permettre, par la miniaturisation des émetteurs et la multiplicité des détecteurs embarqués, une résolution temporelle encore supérieure (actuellement de l’ordre de 200 ms). Celle-ci, même sans modification majeure des possibilités de contraste (il s’agit toujours de mesurer l’atténuation des rayons X, avec ou sans produit iodé intravasculaire), a cependant permis de préciser l’extension des calcifications coronaires (indice pronostique important d’événements cardio-vasculaires), la présence et maintenant le degré de sténose, répondant ainsi aux critères d’une angiographie non invasive, et le caractère « dur » ou « mou » des plaques évaluées (équivalent radiologique des paramètres de réfraction et de rétrodiffusion ultrasonores).

Ces données cardiaques et coronaires risquent de s’accumuler dans les années à venir en raison de l’augmentation du nombre d’examens scanographiques de routine et de l’amélioration de leurs résolutions spatiale et temporelle : en effet, les conclusions du dernier congrès de radiologie américain recommandent de ne pas négliger l’imagerie du cœur obtenue durant l’évaluation de toute affection thoracique extracardiaque, dont on conseille souvent l’acquisition synchronisée à l’ECG.

Sur le plan anatomique, scanner ou IRM sont désormais équivalents pour établir l’origine des artères pulmonaires (figure 9), ou l’abouchement des veines pulmonaires avant cryoablation des foyers ectopiques de fibrillation auriculaire. Mais en ce qui concerne la perfusion myocardique, les études scanner ne permettent qu’une discrimination insuffisante, pour le clinicien, entre myocarde normal et myocarde infarci, et au prix d’une irradiation encore trop forte. Dans cette compétition technologique, l’IRM de perfusion remporte le match et, avec les ultrasons, se qualifie pour les phases finales face au tenant du titre : la scintigraphie.

Enfin, dernier avatar technologique, le couplage d’un scanner avec un détecteur de photons de haute énergie dans le TEP-scan permet la triple acquisition non invasive de l’anatomie coronaire par angiographie, de la perfusion myocardique (en MIBI, H215O ou 13NH3) et de la viabilité par le métabolisme glucidique du 18FDG (figure 10).

C’est vers ce type d’investigation que s’orienteront probablement les techniques d’évaluation de l’athérosclérose coronaire dans les années à venir.

Figure 9. Angiographie RMN 3D : anomalies vasculaires congénitales (gros vaisseaux et coronaires).

Figure 10. Couplage TEP-Scanner.

SPECT monophotonique

Après la mise au point des caméras à scintillations et de la tomographie dans les années 50 et 60, et les premiers protocoles de perfusion myocardique utilisant le thallium dans les années 70 (figure 11), la scintigraphie myocardique représente maintenant l’un des tout premiers postes de la médecine nucléaire. Ses développements, pourtant limités par une faible résolution spatiale, ont profité au cours de ces années des avantages d’une technique non invasive standardisée pour s’imposer comme référence dans le monde entier. Tant sur les plans de la détection de l’ischémie (la douleur de ce patient est-elle d’origine coronaire ?), de la précision du risque (ce fumeur, accro à son paquet quotidien, obèse avec un BMI de 30 kg/m2 et un LDL à 1,8 g/l, a-t-il déjà développé une maladie coronaire préclinique ?) que surtout de l’évaluation pronostique de la maladie coronaire (quelle est la survie de ce coronarien, récemment dilaté sur l’IVA après un infarctus antérieur, dans les 5 ans à venir ?), les réponses apportées par de très nombreuses études portant sur des dizaines de milliers de patients ont désormais une valeur inégalée dans le domaine des explorations cardio-vasculaires.

Figure 11. Scintigraphie de perfusion myocardique.

De plus, la synchronisation à l’ECG a encore affiné ces évaluations, notamment dans le postinfarctus où le calcul des volumes ventriculaires, du remodelage myocardique et de la fraction d’éjection — même un peu moins reproductible que l’angiographie isotopique — permet une stratification plus précise du risque d’événements coronariens majeurs.

TEP

Les émetteurs de positons ont été utilisés dès les années 50, avec une résolution spatiale déjà supérieure à celle de la scintigraphie conventionnelle. Un gain de sensibilité important fut ensuite obtenu par l’utilisation de plusieurs scintillateurs couplés, et la reconstruction des images par rétroprojection, initialement proposée pour le scanner X par Hounsfield — prix Nobel 1979 — rapidement adaptée à la TEP.

Mais c’est la mise au point de couronnes de scintillateurs, faits d’un cristal plus adapté à l’énergie élevée des positons (511 keV) qui améliorera la détection de ces instruments et permettra l’étude des métabolismes cellulaires au début des années 80. Les émetteurs de positons (18Fluor, 15Oxygène, 13Azote ou 11Carbone) sont insérés par radiochimie dans une molécule dont on peut suivre, après injection, intraveineuse le plus souvent, la trace lors des transformations métaboliques au sein de l’organe étudié (en postulant que le métabolisme du substrat marqué, ou radiotraceur, ne soit pas perturbé par la présence de l’isotope instable). Dans ce cadre, l’instrument de production de ces isotopes (cyclotron) est un outil essentiel de la chaîne d’investigation. La durée de vie de ces composés (ou période) étant le plus souvent extrêmement brève (de 2 à 60 min), disposer de cet outil à proximité des patients est donc de première importance pour quantifier les variations métaboliques induites par les cardiopathies.

La TEP a principalement démontré l’importance de la viabilité tissulaire comme facteur prédictif de la récupération myocardique après revascularisation (figure 12). Cependant, un autre domaine pourrait se révéler intéressant dans les années à venir et concerne la démonstration de l’inflammation tissulaire dans l’évolutivité des pathologies vasculaires, en particulier dans l’athérosclérose (figure 13).

Figure 12. Réduction du flux et du métabolisme : absence de viabilité myocardique.

Figure 13. TEP-Scan x b.

IRM

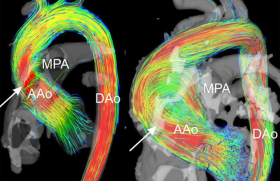

En 30 ans d’existence, l’IRM est devenue la modalité phare de l’imagerie non invasive par ses capacités descriptives de haute résolution, de caractérisation tissulaire et d’imagerie fonctionnelle. Dans l’investigation cardiaque, elle permet de tester les paramètres de perfusion, de viabilité (figure 14), de contractilité (globale, régionale et segmentaire [figure 15]), et d’évaluer les métabolismes, glucidiques ou énergétiques. Pour la partie vasculaire, couplée ou non à l’angiographie ou aux paramètres de vélocité sanguine (imagerie des lignes de flux vasculaires [figure 16] appréciant les turbulences et les forces de cisaillement sur la paroi artérielle), elle fournit une description complète de la maladie athéroscléreuse et de ses conséquences dynamiques. Elle différencie, en effet, les composants de la paroi artérielle sur la base de facteurs tels que la composition et la concentration chimiques (contenu en lipides et en eau), l’état physique (solide, liquide ou cristaux liquides), la conformation, la diffusion et les mouvements moléculaires. Ses différentes approches consistent à utiliser des séquences de contraste liées à la relaxation longitudinale T1 ou transverse T2 (figure 17), des séquences de décalage chimique, de diffusion ou de transfert d’aimantation.

• L’enjeu en pathologie vasculaire est de prédire la rupture des plaques et de guider la décision thérapeutique avant l’apparition des premiers symptômes. Dans ce domaine, de larges études épidémiologiques, de progression et de prévention ont déjà débuté.

Figure 14. IRM cardiaque.

Figure 15. Analyse de la contractilité myocardique intrapariétale et de l’activation ventriculaire.

Figure 16. IRM carotidienne.

Figure 17.

• Mais on peut aussi mesurer les effets des traitements hypolipémiants chez des sujets hypercholestérolémiques asymptomatiques présentant des lésions carotidiennes et aortiques où l’image objective de nets changements pariétaux, suivant un remodelage inverse de celui décrit par Glagov.

• Dans l’artérite des membres inférieurs, la réponse des artères poplitées à l’angioplastie a également été rapportée. Les images révèlent des fissures de plaque et des dissections de paroi passées inaperçues à l’angiographie, en parfait accord avec les modèles expérimentaux publiés.

Ces études témoignent du potentiel important de détection et de suivi de l’IRM tant pour les études de régression que de remodelage ou de resténose, y compris dans le réseau coronaire (figure 18).

Figure 18. Lésion coronaire.

Évolution de la coronarographie

Après l’angiographie non invasive des artères périphériques (carotides, ilio-fémorales, poplitées, rénales) et de l’aorte, l’imagerie actuelle poursuit une marche accélérée vers les coronaires. Cependant, de nombreux problèmes techniques persistent, et c’est à ceux-là que se consacrent encore les ingénieurs, physiciens et informaticiens qui, des centres de recherche aux grands constructeurs, créent nos futurs outils.

Le scanner multibarrette

Quel est l’état actuel de son développement ? La souplesse d’emploi du scanner multibarrette est un atout énorme dans ce débat. Il s’agit d’une technique robuste, dont les effets secondaires (néphrotoxicité de l’iode ou contre-indications des radiations ionisantes) sont parfaitement connus. Ses inconvénients résident dans une faible résolution temporelle, malgré la synchronisation cardiaque, avec laquelle il ne peut être question de visualiser une cible aussi petite et mobile que les artères coronaires distales qui présentent des déplacements plus de 20 fois supérieurs à leur taille (figure 19). Or, pour tirer le meilleur parti des possibilités techniques de ces instruments, il faut souvent choisir entre résolution spatiale et temporelle.

Figure 19. MSCT et IRM : angiographie coronaire non invasive et imagerie de la plaque.

IRM 3D

L’IRM 3D a tenté de s’affranchir de cette contrainte, mais n’a pu encore s’imposer en raison du temps trop long nécessaire à ces acquisitions. Les données actuelles montrent que les artères de patients coronariens ne sont correctement visualisées que sur leurs premiers centimètres (la totalité pour le tronc commun, 6 à 10 cm pour la coronaire droite, 6 à 8 cm pour l’IVA, 4 à 6 cm pour la circonflexe plus profonde et plus distante des sondes).

Dans les centres où l’on a tenté d’intégrer ces techniques avec des séquences de routine clinique, ces résultats sont plus décevants :

- de nombreux patients ne bénéficient pas d’une imagerie complète de leur réseau proximal,

- un pourcentage important d’artères n’est pas correctement visualisé.

Face à ce constat, le scanner est beaucoup plus facile d’utilisation et devrait voir fleurir ses indications de coronarographie non invasive.

Les possibilités de l’IRM restent cependant immenses :

- exploration de multiples paramètres biologiques (vélocité, perfusion, réserve coronaire, structure de la paroi, contractilité, contrainte, orientation des fibres, réserve énergétique),

- images de très nombreuses conditions physiopathologiques (inflammation, œdème, viabilité myocardique, nécrose cellulaire, instabilité de l’athérome) et ces richesses sont encore peu exploitées.

D’importantes contraintes limitent encore son utilisation :

- l’absence de standardisation des protocoles d’acquisition et la difficulté de choisir parmi les multiples séquences dont il faut redéfinir à chaque indication les paramètres de contraste et qui se diversifient chaque année ;

- le coût d’installation et d’exploitation ;

- le peu d’appareils disponibles en France pour l’exploration cardio-vasculaire ;

- l’environnement protégé amagnétique des salles d’examen ;

- l’impossibilité d’explorer les patients porteurs de pacemakers ou de défibrillateurs.

Mais il convient aussi de préciser le cahier des charges de ces techniques dans le cadre général de l’imagerie non invasive : elles doivent détecter ou éliminer les problèmes majeurs (sténose du tronc commun, trajets proximaux des principales artères) et fournir un repère pronostique fiable, même si elles ne permettent pas d’éliminer à 100 % une atteinte distale ou de prédire le prochain événement cardiaque — mais la coronarographie classique y parvient-elle toujours ? Cela est d’ailleurs aujourd’hui le rôle dévolu à la scintigraphie de perfusion myocardique. La coronarographie non invasive pourrait donc fort bien s’associer à elle pour tout bilan coronarien, avant de franchir le versant invasif et thérapeutique.

Imagerie cellulaire et moléculaire

Dans ce domaine, ultrasons, isotopes et résonance magnétique œuvrent de concert pour authentifier les acteurs métaboliques les plus importants des différents processus physiopathologiques.

• Historiquement, les radio-isotopes ont été les premiers à occuper ce créneau par le couplage de la biochimie de marquage (radiochimie) et de l’imagerie in vivo.

• Depuis, un grand nombre de molécules ont été couplées à des traceurs radioactifs afin de tester le métabolisme de cellules actives ou quiescentes, après internalisation par des récepteurs, spécifiques le plus souvent (récepteurs Glut-1 pour le FDG par exemple). Certains essais ont couplé des microbulles à des anticorps monoclonaux pour cibler l’endothélium inflammatoire ou des interactions médicament-récepteur, avec détection ultrasonore de ces liposomes acoustiques.

• Enfin, d’autres molécules, telles que des anticorps, des peptides, des polysaccharides ou des médicaments, sont maintenant couplées au gadolinium (gadofluorine [figure 20]) ou aux oxydes de fer (USPIO), agents para- ou superparamagnétiques, modifiant la relaxation transverse et longitudinale des tissus environnants et générant un contraste fort en IRM. De tels agents sont utilisés pour la détection de l’activité de clivage des métalloprotéases (enzymes majeures du remodelage artériel et ventriculaire), de l’expression de molécules d’adhésion endothéliale (ICAM-1, VCAM-1), de certaines étapes de l’angiogenèse, de l’activation plaquettaire ou de la thrombose artérielle.

Figure 20. Gadofluorine, marqueur de l’infiltration lipidique artérielle en IRM.

PACS et télémédecine : rêves et difficultés de la médecine désincarnée

Une autre révolution dans le domaine de l’imagerie médicale a été rendue possible par l’évolution des télécommunications et d’Internet. À une échelle locale, nationale ou internationale, la télémédecine inclut :

- l’aide au diagnostic (transmission d’images médicales — rendues anonymes si nécessaire — et de données cliniques),

- le conseil thérapeutique pour les soins médicaux et chirurgicaux (vidéo-assistance pour des interventions à distance),

- la formation des médecins et les échanges scientifiques (nous apportant à chaque instant un lot considérable d’informations par les articles et figures des revues spécialisées).

Elle permet aussi de bénéficier des conseils de médecins expérimentés (imagerie, chirurgie spécialisée) et de gérer des situations à distance avec maintien des patients dans les hôpitaux d’accueil.

Dans les pays en développement où les ressources sont limitées, elle peut être un atout considérable pour les patients.

Un exemple

Au Cambodge, où les élites ont été décimées durant la période Khmère rouge et les infrastructures ravagées par 30 années de conflit, le nombre de médecins spécialistes et les structures médicales sont encore très limités.

En 2000, une association de radiologues français a fait don d’un premier scanner à un médecin franco-khmer travaillant dans une clinique de Phnom Penh. Face à un diagnostic difficile, les médecins cambodgiens envoient leurs images par Internet à Poitiers où les radiologues donnent leurs conclusions sous 48 heures.

Un adolescent est ainsi récemment adressé au Centre cardiologique de Phnom Penh pour syndrome cave supérieur : l’échocardiographie montre une masse tumorale extracardiaque. Le scanner, réalisé sur place et interprété en France, précise alors l’étendue des lésions autour des gros vaisseaux et une biopsie chirurgicale, réalisée les jours suivants, lors d’une mission de chirurgiens français au CCPP, confirme le diagnostic de lymphome malin médiastinal.

La télémédecine est avant tout conditionnée par les infrastructures de télécommunication. Le Cambodge, stabilisé depuis 1997 et bénéficiant de l’aide et de la coopération françaises depuis 10 ans, a connu une évolution rapide avec la présence dans la capitale de plusieurs providers aux prix de connexion abordables. Mais tous les pays en développement ne peuvent encore bénéficier de ce type d’opération compte tenu des coûts élevés d’équipement, d’installation et d’entretien des lignes, et de la faiblesse de leurs réseaux. Cependant plusieurs projets de ce type pour des pays particulièrement démunis sont en cours d’élaboration, au sein de la Communauté Européenne, aux Nations-Unies ou à l’OMS, ce qui pourrait contribuer à fournir un accès plus équitable de ces populations aux services de santé.

Conclusion

Depuis 20 ans, le choc des cultures scientifiques — sciences dites « dures » contre sciences biomédicales (qui n’en sont pas plus douces) — s’est déroulé sous nos yeux pour aboutir à cette efflorescence d’options diagnostiques. Dans ce débat d’image, le médecin s’est appuyé sur l’informaticien et le physicien avec lesquels il a partagé ses engagements face à la souffrance. Mais comme l’anatomo-pathologiste du XIXe siècle, qui concluait en dernier ressort (figure 21), il nous faut éviter de surligner cette caricature d’un médecin « photographe d’intérieur », entretenant un lointain rapport avec la vie, un « imageologue » qui ne soit plus le soignant, mais auquel tout le monde se réfère dans le souci de techniciser nos décisions et d’éviter toute contradiction opposable.

Confronter le virtuel à la réalité reste le combat quotidien de nos prochaines années.

Figure 21.

Attention, pour des raisons réglementaires ce site est réservé aux professionnels de santé.

pour voir la suite, inscrivez-vous gratuitement.

Si vous êtes déjà inscrit,

connectez vous :

Si vous n'êtes pas encore inscrit au site,

inscrivez-vous gratuitement :